반응형

출처:http://premium.chosun.com/site/data/html_dir/2016/04/01/2016040101289.html

인간만이 갖고 있는 직관(直觀), 수많은 경험을 조합한 판단, 상대방이 두는 낯선 수에 대한 대응에 이르기까지 갓 태어난 알파고 앞에는 미지의 세계가 펼쳐져 있었다. 단지 기존의 인공지능처럼 계산 속도를 빠르게 하는 것만으로는 충분하지 않았다. 그래서 알파고는 사람처럼 바둑을 배우기 시작했다.

3주간 집중훈련

붙이면 젖혀라, 모자는 날일자로 벗어라…

행마·사활·기보를 ‘정책망’에 입력

행마·사활·기보를 ‘정책망’에 입력

인간의 뇌는 신경세포들의 연결체이다. 신경세포들은 전기신호를 주고받는다. 공부를 하거나 경험을 하면 신경세포의 연결망이 재조직되거나 연결 강도가 바뀌면서 기억이나 판단 능력이 생긴다. 알파고의 핵심 능력은 사람의 뇌를 본뜬 인공 신경망에서 나온다. 알파고의 인공 신경망은 크게 ‘정책망(policy network)’과 ‘가치망(value network)’으로 나뉜다. 먼저 세 종류의 정책망이 알파고가 만들어진 뒤 3주 동안의 집중 학습을 통해 형성됐다.

우선 ‘롤아웃(rollout) 정책망’에는 바둑의 기본이 들어 있다. 바둑에는 격언처럼 전해오는 일종의 규칙이 있다. ‘붙이면 젖혀라’, ‘젖히면 뻗어라’, ‘모자는 날일자로 벗어라’ 등 바둑을 배운 사람이라면 누구나 별다른 생각없이 가장 좋은 수로 여기는 규칙들이 롤아웃 정책망으로 학습된다. 이어 딥마인드는 알파고에게 아마추어 고수들이 인터넷에서 둔 바둑 기보(棋譜) 16만건을 공부시켰다. 특정한 상황을 보여주고 다음에 사람이 어디에 두었는지 맞히는 문제를 3000만개 풀었다. 이를 통해 얻은 경험은 ‘지도학습 정책망(supervised learning)’에 업데이트됐다.

하지만 16만건의 바둑 기보는 바둑을 알기엔 턱없이 부족하다. 이 때문에 알파고는 수없이 가상 대국을 두며 새로운 수를 찾았다. 알파고는 혼자서 하루에 3만번 바둑을 두면서 배운 것들을 하나하나 따져보고 검증했다. 기보에 없는 수를 둘 경우 어떻게 되는지, 어떤 수를 둬야 이길 확률이 높은지 자율학습을 통해 깨달은 것이다. 이 정보는 ‘강화학습(reinforcement learning) 정책망’에 쌓였다.

학생들이 수학을 배우는 과정에 비유하면 롤아웃은 공식, 지도학습은 연습 문제 풀이, 강화학습은 증명에 도전하는 과정이라고 할 수 있다. 어떤 상황에서 어떤 수가 좋다는 것을 알파고가 알게 된 것은 사람의 뇌에서 신경세포들의 연결이 변해 경험이 쌓이는 것과 비슷하다. 프로 바둑기사들은 다음에 둘 곳을 ‘직감’으로 몇 곳 추린 뒤 그 뒤에 벌어질 일을 예상해본다. 알파고는 정책망으로 프로기사처럼 다음 수를 어디에 둬야 좋은지 추릴 수 있게 됐다. 인간의 직관력을 흉내 내게 된 것이다.

이기는 게임엔 무리수 안 둬

정책망을 통해 추려낸 수 후보들의 승률 분석

이 부분을 맡는 신경망이 ‘가치망’이다

이 부분을 맡는 신경망이 ‘가치망’이다

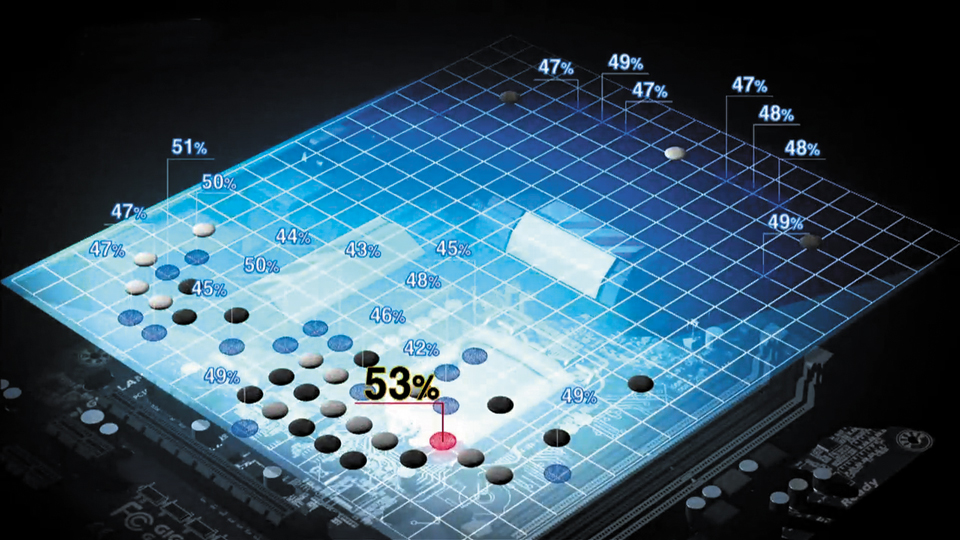

알파고는 정책망으로 현재 상황에서 어떤 수가 좋다는 것은 비교적 잘 알게 됐지만, 전체적인 바둑이 유리한지 불리한지는 판단할 수 없었다. 형세를 판단할 수 없다는 뜻이다. 프로 바둑기사들은 ‘기분 좋은 형세’라는 말에서 알 수 있듯 감(感)으로 형세를 판단한다. 사람이 논리적으로 설명할 수 없는 것을 알파고에 입력하기는 힘들다. 알파고는 가치망이라는 또 다른 신경망을 이용, 정책망을 통해 추려낸 다음 수 후보들의 승률을 추정한다.

바둑판에서 한 점에 돌을 놓으면 그다음에 돌을 놓을 수 있는 다양한 점들이 나온다. 이 점들도 각각 그다음에 가능한 여러 점들을 쭉 나열할 수 있다. 이는 마치 한 가지에서 여러 가지가 계속 나오는 나무(트리) 모양새가 된다. 가치망에는 이와 같은 가지 중 일부를 선택하는 ‘몬테카를로 트리 서치(MCTS)’라는 방식이 사용된다. 다음 수 후보들을 뒀을 때 생겨나는 경우의 수 중 일부만을 무작위로 시뮬레이션해본 뒤 이를 근거로 승률을 얻어내는 방법이다. 마치 방송국에서 TV 프로그램 시청률을 집계하기 위해 일부 가구만 표본조사하는 것과 비슷하다. 시청률 조사는 많은 가구를 조사할수록 정확하다. 알파고는 후보 수마다 10만번에 이르는 시뮬레이션 결과를 얻어내는 것으로 알려져 있다. 가치망을 통해 알파고는 현재 상황에서 자신의 유불리를 파악할 수 있다. 정책망과 가치망을 활용해 알파고는 아무리 상대방이 최선의 수를 둬도, 그보다 더 승률을 높이는 수를 판단할 수 있게 됐다.

[출처] 본 기사는 조선닷컴에서 작성된 기사 입니다

반응형

'IT기술 관련 > A.I 인공지능' 카테고리의 다른 글

| 쉽게 풀어쓴 딥러닝(Deep Learning)의 거의 모든 것 (0) | 2016.06.02 |

|---|---|

| CS231n : Image Classification: Data-driven Approach, k-Nearest Neighbor, train/val/test splits (한국어 번역) (0) | 2016.06.02 |

| 머신러닝과 딥러닝 어떻게 다를까? (0) | 2016.06.01 |

| 컨볼루션 네트워크 (0) | 2016.06.01 |

| 몬테카를로 트리서치, 무작위 시뮬레이션 통해 승률계산 (0) | 2016.06.01 |

random-160318051918.pdf

random-160318051918.pdf